Proposta di un algoritmo di Reinforcement Learning.

Marzo 1, 2022Risultati del funzionamento dell’algoritmo di Reinforcement Learning.

Dopo aver applicato il concetto di sensibilità all’algoritmo di Reinforcement Learning, i risultati sono migliorati rispetto alla prima versione. Di seguito, riporto alcuni tests.

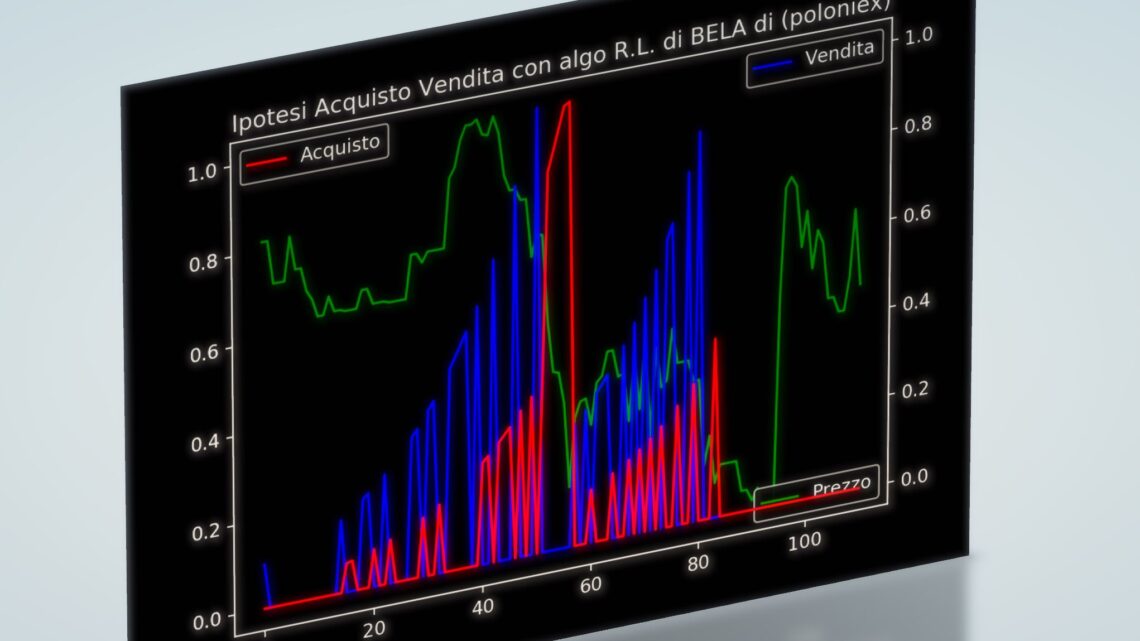

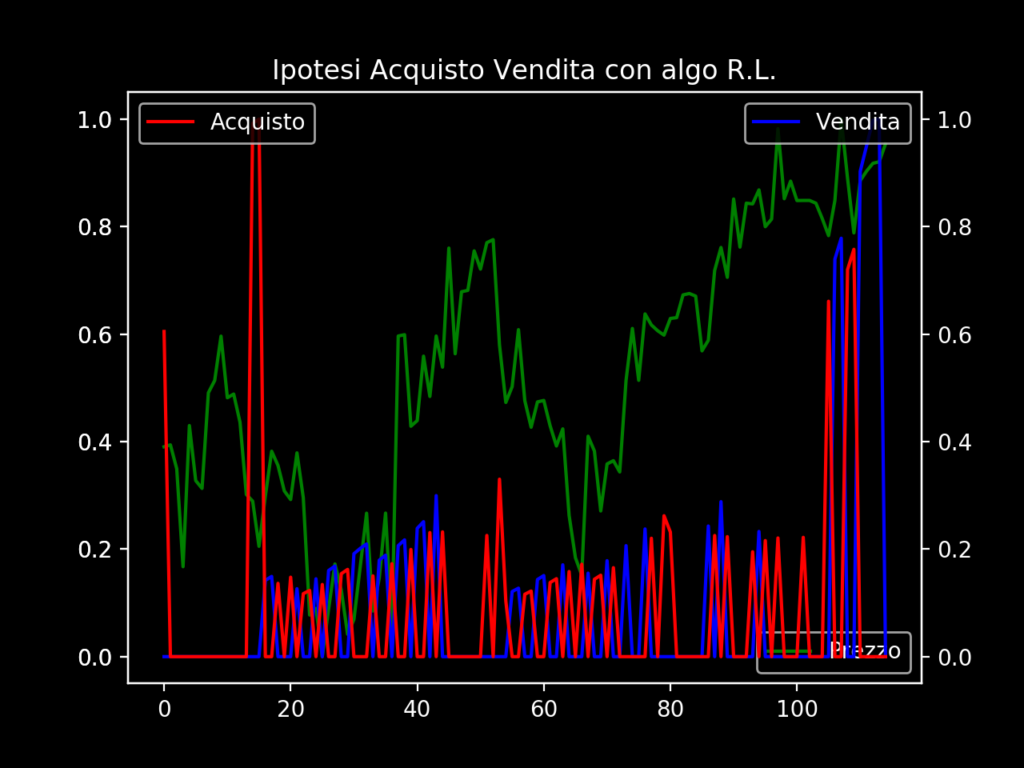

(Primo risultato della seconda versione dell’algoritmo di RL).

Come si può vedere acquisto e vendita avvengono in ben precisi momenti dell’andamento della pair ZEC/BTC. L’acquisto nel momento del minimo (evidenziato nel grafico dal più alto valore della linea rossa) e la vendita in alcuni momenti di massimo (evidenziato nel grafico dal più alto valore della linea blu). La vendita non avviene ancora nei momenti di massimo, ma sicuramente il risultato è migliore del primo algoritmo.

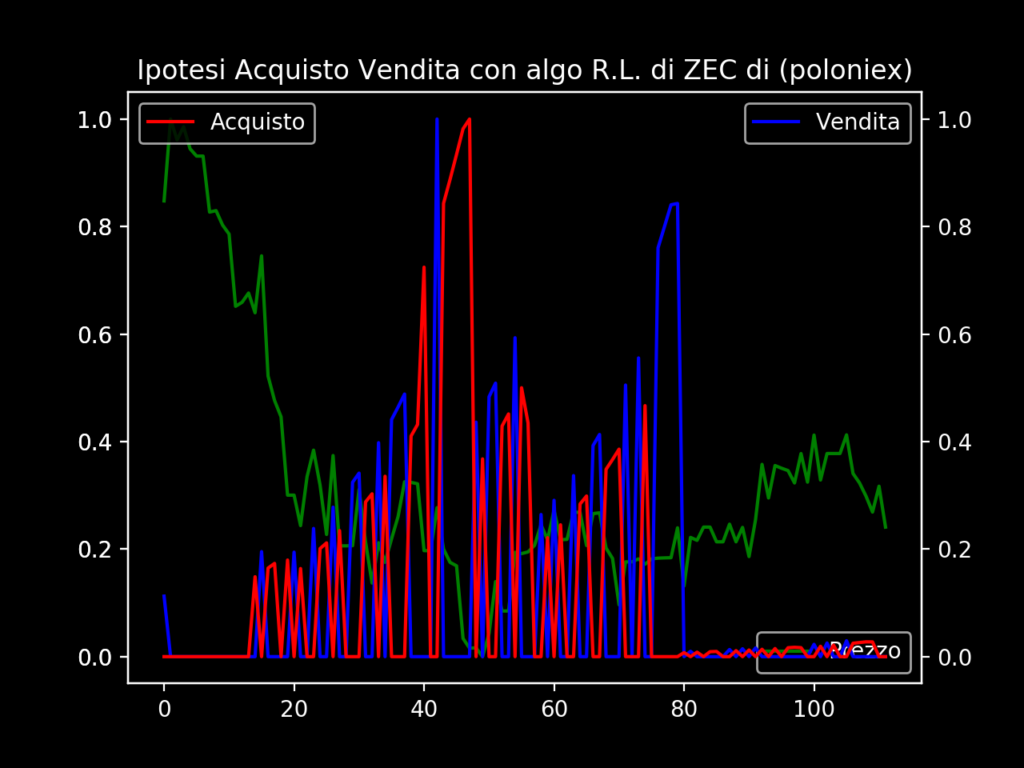

(Secondo risultato della seconda versione dell’algoritmo di Reinforcement Learning).

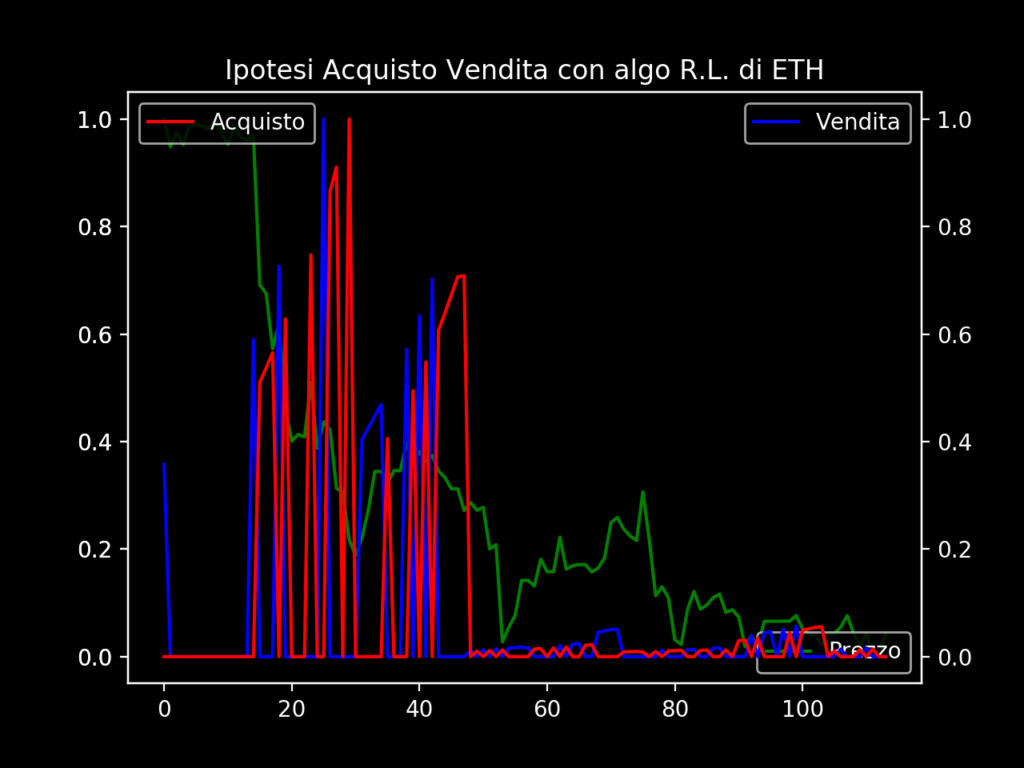

(Terzo risultato della seconda versione dell’algoritmo di Reinforcement Learning).

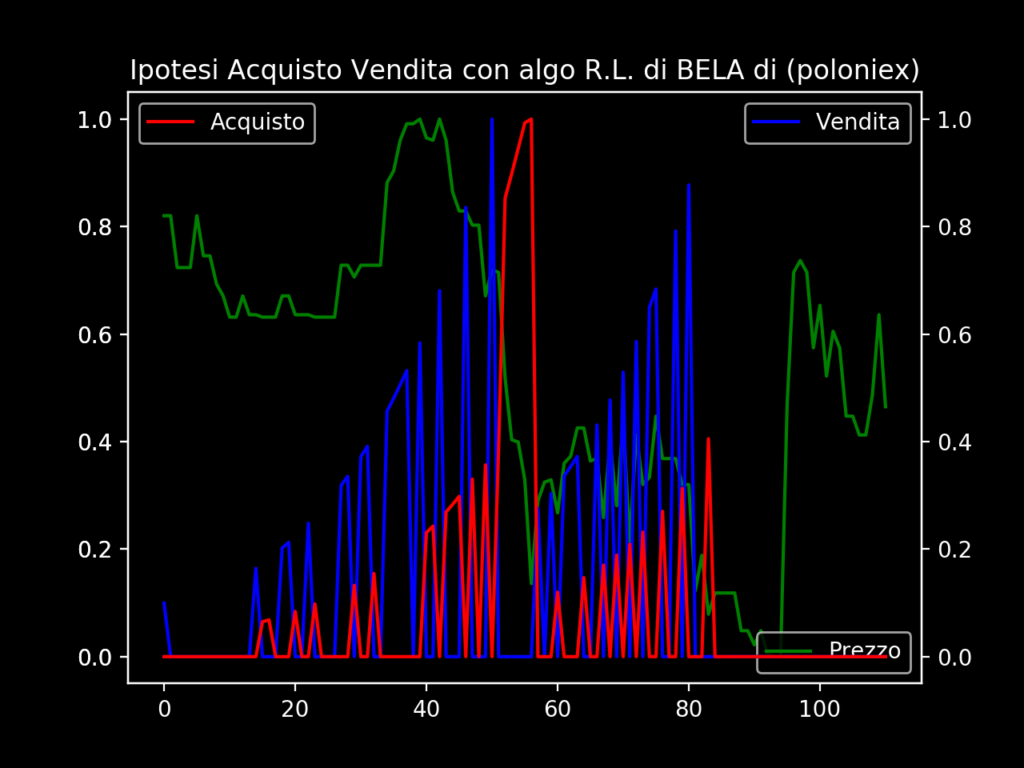

(Quarto risultato della seconda versione dell’algoritmo di Reinforcement Learning).

Questi sono alcuni dei risultati, ed è ovvio, che l’algoritmo dovrà essere ottimizzato ulteriormente o come dicono in molti, in modo poco appropriato, si dovranno attuare delle azioni di fine-tuning.

Come al solito, per eventuali domande e integrazioni inviate un e-mail a webmaster@megalinux.cloud. Aiutate a sostenere The Megalinux, l’unico sito nel Web senza pubblicità inviando Bitcoin al seguente indirizzo.

3LpoukFpvDHTZPn5qGbLwUzve3rX9zsSq6